Répondre à un QCM : Aspects cognitifs#

Informations

Auteurs : Philippe Dessus, Inspé & LaRAC, Univ. Grenoble Alpes. Le quizz a été réalisé par Émilie Besse, projet ReFlexPro.

Date de création : Septembre 2015.

Résumé : Ce document décrit les processus cognitifs engagés dans l’activité de réponse à des questionnaires à choix multiple.

Introduction#

Comme l’indique Frederiksen [Frederiksen, 1981], tout test censé évaluer des connaissances ou performances en contexte éducatif influe sur le comportement des apprenants, et même celui des enseignants (qui ont de fait tendance à enseigner ce qui va être testé). Tous peuvent vouloir le réussir, et donc adopter diverses stratégies augmentant la pression en temps, charge mentale, travail. Introduire des tests (quelle que soit leur forme) dans un système éducatif introduit un biais. Voyons dans cette section quels peuvent être les avantages et inconvénients des QCM, si on les compare principalement aux RC (réponses construites, donc produites par l’apprenant).

Pour résumer, s’il est possible de concevoir des items de QCM assez proches des RC pour des raisons pratiques, les apprenants les passant ne mettent pas exactement en œuvre les mêmes niveaux de connaissances, et leur difficulté n’est pas non plus identique.

Les comparaisons des formats des items#

Bien évidemment, le format des réponses attendues (RC vs. CM) va également jouer un rôle dans la manière dont un apprenant pourra apprendre et réviser son cours. Frederiksen signale qu’un étudiant se sachant évalué via QCM va se centrer plus sur les faits, les dates, les définitions (de petites unités d’information), et sera peut-être moins centré sur des habiletés moins évaluables par QCM, ou des unités plus générales. Sur le long terme, un apprenant uniquement évalué par QCM pourra perdre d’autres habiletés pourtant indispensables, comme celles de formuler des raisonnements par écrit.

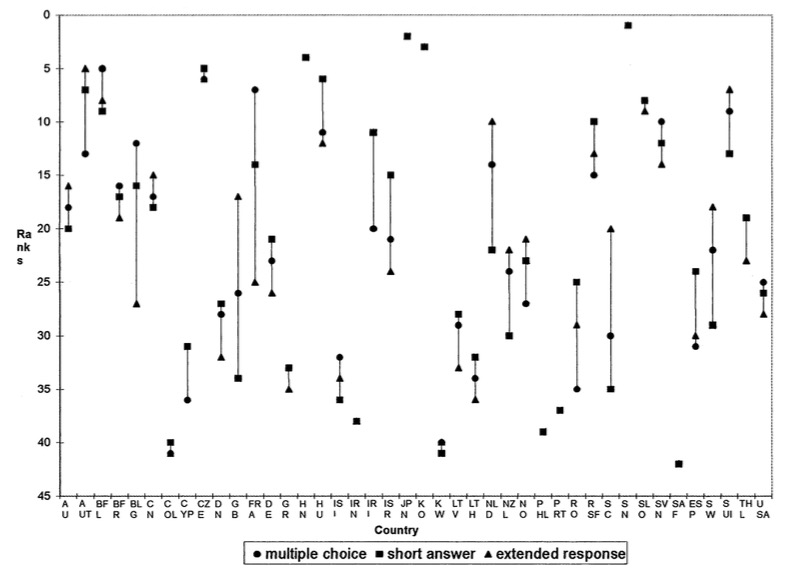

Une étude internationale à large échelle, à partir des données du TIMMS (Third International Mathematics and Science Study) [Schmidt et al., 1998] compare, par pays, la réussite des élèves en mathématiques et sciences. Elle montre un effet non négligeable du format de passation des tests (voir Figure 1) : la différence des rangs selon le type de test va de 0 à 20, avec une moyenne de 5.

Figure 1 - Rang des pays au TIMSS (mathématiques) selon le format des tests ([Schmidt et al., 1998], p. 518).

Quelques avantages des QCM#

Nous avons déjà indiqué les aspects intéressants des QCM, liés à la facilité de les mettre en œuvre à large échelle. Il est par exemple intéressant de noter que des études ont montré des corrélations élevées entre des tests RC (réponses construites) et CM (choix multiple). Rodriguez [Rodriguez, 2003] s’est intéressé à synthétiser près de 70 études visant à corréler les résultats de performance de participants évalués par des tests RC vs. CM. Il montre une corrélation moyenne élevée de .87 entre les tests RC et CM (montant à .95 quand les questions sont équivalentes) ce qui signale un lien important entre les performances mesurées par les deux méthodes.

Une autre étude [Bleske-Rechek et al., 2007] avait le même design à propos de performances d’étudiants en psychologie. Elle a montré elle aussi une corrélation entre leurs résultats QCM vs. RC (réponses construites), mais aussi que les scores des étudiants au QCM sont mieux reliés à leurs scores de réussite universitaire générale que ceux aux réponses courtes. Il semblerait donc que les performances des étudiants à des QCM aient un lien plus important avec leur performances académiques que celui souvent estimé par leurs détracteurs. D’autres auteurs (voir [Frederiksen, 1981, Shepard, 2008]) ont des analyses plus nuancées sur ce point, en signalant que les similitudes de performances sont surtout présentes quand les questions sont identiques.

Les tests via QCM, s’ils sont maintenant très répandus à tous niveaux scolaires, souffrent de deux préjugés que nous allons détailler ici. Le premier est que les QCM ne peuvent mesurer que des compétences de bas niveau dans l’échelle de Bloom et al. [Bloom et al., 1969] (p. ex., rappeler des faits). Le second, que le fait de répondre à un test ne fait que prélever de l’information sur ce que peut connaître un apprenant sans aucunement interagir avec cette connaissance ni l’affecter.

Les effets bénéfiques des QCM sont les suivants [Marsh et al., 2007] : ils donnent l’occasion d’exercer sa mémoire (reconnaître des informations), d’étudier un contenu, et les différents indices donnés dans les réponses de choix sont traités en tant que problèmes, ce qui peut, là encore, améliorer l’apprentissage. De plus, comme les étudiants ont rapidement connaissance de ce qu’ils ne maîtrisent pas, ils peuvent en entreprendre l’étude. Du point de vue de l’enseignant, ils sont aisés à corriger, donc informatisables souvent utilisés quand les cours ont un grand nombre d’étudiants.

Parmi les inconvénients connus des QCM : ils sont difficiles à réaliser, tout apprenant peut, en répondant au hasard, espérer avoir une note acceptable (à tout le moins, non nulle), ils induisent également l’apprentissage de mauvaises réponses, puisqu’elles sont traitées cognitivement par l’apprenant. Ils ne favorisent pas, non plus, la production d’écrits. Et les QCM dans le monde réel sont plutôt rares (voir toutefois un certain nombre de jeux, informatisés ou non, qui en empruntent la forme, et leur usage de plus en plus massif durant l’enseignement en confinement), ce qui rend son usage assez peu authentique [Williams, 2006]. Du point de vue de l’enseignant, également, ils sont assez difficiles à construire, puisque les réponses distractrices doivent être à la fois plausibles et fausses (voir Les questionnaires à choix multiple : définitions et critiques).

Les processus cognitifs engagés dans les QCM#

Il est habituellement considéré que la réponse aux QCM n’incite pas les apprenants qui les formulent dans des processus cognitifs de haut niveau, puisque nécessairement fondée sur la reconnaissance d’informations plutôt que leur formulation (puisque les réponses sont nécessairement formulées par avance pour être choisies). Le fait qu’on puisse y répondre totalement au hasard est en grande partie responsable de cela (voir [Leclercq, 2006] pour une discussion de ce point). De plus, une étude expérimentale récente [Agarwal, 2019] montre, effectivement, qu’il n’y a pas de transfert entre l’entraînement à répondre à des questions factuelles et celui à répondre à des questions de haut niveau. Le Document Écrire des questions d’examen à l’épreuve de la tricherie donne d’autres exemples d’utilisation des QCM pouvant être utilisés comme des questions d’examen à l’épreuve de la tricherie (donc moins orientés rappel que réflexion).

Toutefois, comme l’ont signalé Roid et Haladyna [Roid & Haladyna, 1980], il est possible de centrer des QCM sur d’autres activités que la simple sélection de faits. Ils distinguent, en adaptant la taxonomie des objectifs cognitifs de Bloom et ses collègues [Bloom et al., 1969], 5 niveaux (voir le Tableau 1 ci-dessous, qui montre le type d’amorces amenant des activités plus complexes qu’une simple sélection-reconnaissance de réponse). En d’autres termes, entraîner les apprenants à répondre à ces questions de plus haut niveau les entraînera effectivement sur ces compétences [Agarwal, 2019].

Tableau 1 – Un exemple de typologie cognitive de l’écriture d’items de QCM ([Roid & Haladyna, 1980], p. 299).

Activité cognitive |

Définition |

Formes |

Exemple de question-amorce |

|---|---|---|---|

Rappeler des faits |

La reproduction d’un élément-stimulus identique à celui présenté |

Nommer , Sélectionner, Décrire |

À quelle date Christophe Colomb a-t-il découvert l’Amérique ? a. 1492 ; b. 1489 ; c. 1776 |

Résumer |

La compréhension des concepts et la capacité à identifier correctement les exemples, instances ou attributs du concepts |

Identifier, Définir, Traduire |

Quel est un bon exemple d’allitération [en anglais] ? c. gurgling ; b. school–pool ; c. blue–blood ; d. up–down |

Prédire |

Utiliser des règles pour mettre au jour des relations de contingence entre items d’apprentissage L’apprenant lit une situation et peut anticiper une conséquence fondée sur une règle. |

Si… alors… |

Si la température du fluide dans la bouteille excède 100°C, alors, a. tous les fluides s’évaporeront ; b. le liquide explose ; c. rien ne se passe |

Evaluer |

La capacité à a) sélectionner un ou des critère(s), b) utiliser un critère, c) sélectionner et utiliser un critère pour mettre en œuvre une décision. |

Quel item est le meilleur, le pire, le plus, le moins, etc. |

Du point de vue de l’efficacité, quelle procédure est la meilleure ? a. procédure 1 ; b. procédure 2, c. etc. |

Appliquer |

Résolution d’un problème impliquant a) le comprendre ; b) le définir ; c) choisir des principes, règles ou méthodes qui permettront de le résoudre ; d) choisir ou trouver des solutions. |

Pas de formes standard. |

Quel plan permettra de réaliser un système de distribution urbaine de l’eau qui sera efficace en toutes saisons ? a. nappe phréatique à l’ouest de la ville ; b. nappe phréatique à l’est de la ville ; c. un réservoir dans les collines ; d. un pipeline |

De plus, Marsh et al. [Marsh et al., 2007] reportent que les effets d’un QCM sur l’apprentissage sont aussi importants lorsque le QCM porte sur des aspects définitionnels (niveau 1 de la taxonomie de Bloom) que sur des aspects d’application (niveau 5 de la définition). Un travail plus récent [Tractenberg et al., 2013] montre même qu’il peut exercer les niveaux les plus élevés de la pensée critique.

Néanmoins, il est erroné de penser que les QCM permettent d’évaluer tout type de connaissance ou performance d’apprenant. Shermis et Di Vesta [Shermis & J, 2011], p. 163-164, en listent les limites. Les QCM permettent difficilement l’évaluation :

d’explications (p. ex., expliquer les effets d’un phénomène) ;

de raisonnements complexes ;

des stratégies utilisées dans la résolution d’un problème ;

d’opinions personnelles ;

d’idées originales ou de nouvelles stratégies, exemples ;

d’habiletés (p. ex., d’une discussion, d’un débat, etc.).

Enfin, une étude [Jonsson et al., 2017] ayant eu pour but de comparer l’activité d’étudiants répondant à des QCM issus de questionnaires ouverts pour évaluer leur connaissances en raisonnement en physique montre qu’ils font majoritairement appel à des connaissances générales et à leur connaissance de ce qu’est un test de QCM (deviner la bonne réponse et/ou éliminer les réponses erronées), plutôt qu’à des connaissances spécifiques en physique que le test est censé mesurer. Leur difficulté générale a été aussi évaluée comme moins grande que celle des questionnaires ouverts correspondants.

Les QCM font-ils apprendre ?#

L’effet de test#

Un avantage peu mis en avant mais souvent évoqué dans la littérature de recherche est qu’il améliore l’apprentissage (une méta-analyse récente de [Sotola & Crede, 2020] montre une taille d’effet moyenne de .42 des quizz sur la réussite) : des apprenants confrontés à un apprentissage et passant un test à son propos ont de meilleures performances que des apprenants qui réalisent l’apprentissage sans passer le test [Bangert-Drowns et al., 1991]. Cela est dû à un effet bien connu dans le domaine de l’étude de l’apprentissage, l’effet de test (testing effect) : une information rappelée de la mémoire à long terme, par exemple lors d’exercices d’entraînement, sera plus aisément retrouvable (activable) par la suite, par exemple lors de l’examen final [McDaniel et al., 2007]. Toutefois, cet effet de test ne paraît être observé que pour la compréhension de matériel simple (rappel de faits) et non complexe [Gog & Sweller, 2015].

Les QCM sollicitent principalement une activité de reconnaissance (reconnaître la bonne réponse parmi plusieurs). Cela a un inconvénient majeur : les apprenants doivent lire des réponses erronées, et le danger est grand qu’ils les apprennent (ce que les études de Butler ont confirmé). Pour pallier ce risque, il convient de donner, par des rétroactions, les bonnes réponses à l’apprenant dans un délai raisonnable après la passation du QCM (cela peut être aussi lié à un épuisement des ressources de mémoire de travail, créé par la passation du test ; attendre la fin du test permet de récupérer ces ressources, voir [Chen et al., 2017]). Sadler [Sadler, 1999] a également montré qu’il est possible de construire des QCM en indiquant, comme choix possibles, les compréhensions erronées des apprenants.

Enfin, cela donne une idée plus précise aux élèves de ce qu’il est nécessaire de maîtriser, en termes de contenu, pour réussir (notamment, mais pas uniquement, les examens), en leur permettant de se centrer mieux sur le contenu. Une étude l’a montré [Szpunar et al., 2013], en comparant les occurrences de comportements centrés sur la tâche (prise de notes) et non-centrés (rêveries) d’étudiants d’un cours d’introduction en statistiques. Les étudiants du groupe où chaque partie du cours était suivie d’un bref test QCM ont pris significativement plus de notes et ont été moins portés à s’évader mentalement du cours que ceux du groupe de contrôle. De plus, les étudiants du groupe expérimental ont été moins anxieux lors des examens.

Latimier et ses collègues [Latimier et al., 2019] ont montré, avec une étude sur près de 300 participants tout-venant, que les personnes passant un QCM de test de connaissances après lecture d’un contenu avaient une meilleure performance (taille d’effet .74) à un test final que celles passant le test avant lecture (taille d’effet .35, ces deux groupes réussissant mieux que le groupe ne réalisant aucun test).

Où on apprend un peu plus que prévu#

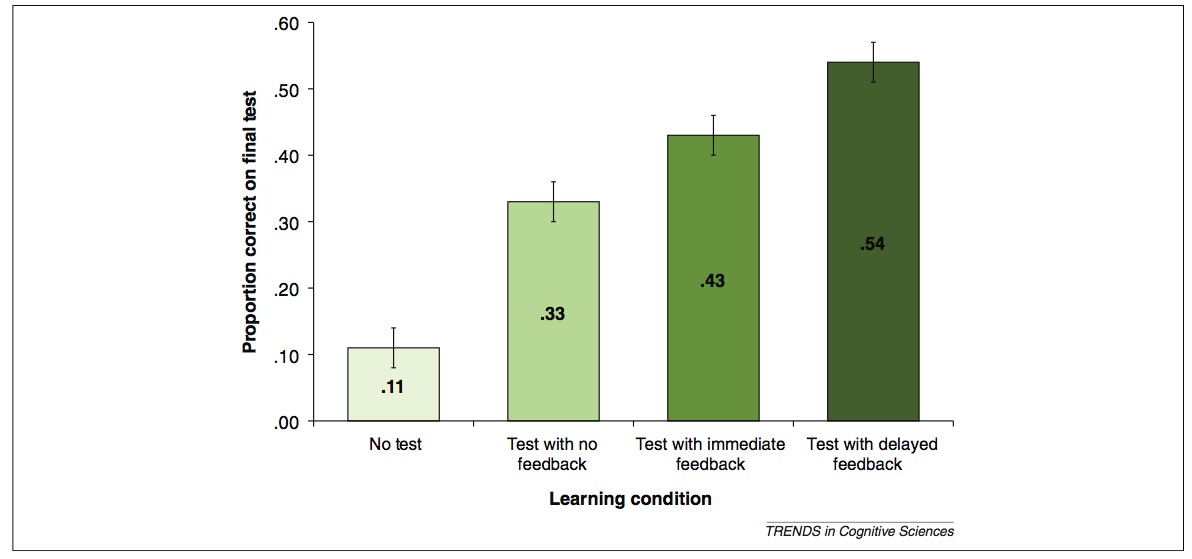

De nombreuses recherches ont eu pour but de valider, d’un point de vue cognitif, la passation de QCM auprès d’apprenants. Roediger et Butler [Roediger & Butler, 2011] en font une synthèse intéressante. Le résultat le plus frappant est de montrer que, contrairement à ce qui est communément pensé, le simple fait d’exposer des apprenants à un test leur fait apprendre un peu plus que le matériel auquel ils ont été exposés dans le test. Ces auteurs ont réalisé une expérimentation [Butler & Roediger, 2008] dans laquelle des apprenants devaient étudier un matériel à apprendre (un cours d’histoire sur les Khmers rouges), puis étaient confrontés à un test de compréhension final. Puis ils étaient répartis en 4 groupes. Les résultats sont décrits dans la Figure 2 ci-dessous :

sans test (aucun test intermédiaire) ;

test intermédiaire sans feedback ;

test intermédiaire avec feedback (donnant les réponses correctes) ;

test avec feedback reporté à la fin du test.

Figure 2 - Les 4 conditions d’apprentissage de l’expérience de Butler et Roediger [Butler & Roediger, 2008], repris de [Roediger & Butler, 2011], p. 23.

Une autre étude [McDaniel et al., 2012] a même montré que faire passer un QCM avec correction immédiate à des étudiants à des fins de révision avant un contrôle donnait les mêmes résultats que leur faire répondre à des questions ouvertes et courtes, et des résultats supérieurs à la simple relecture du cours. Point plus important, les étudiants réussissent également mieux à répondre à des questions reliées au cours, mais non similaires (p. ex., une question sur l’information arrivant dans une structure du cerveau vs. en sortant). Cela peut s’expliquer de deux manières [Bjork et al., 2014] : soit les étudiants révisent efficacement les lacunes pointées par les rétroactions du QCM, soit une réflexion à propos des différentes réponses possibles les amène à approfondir les relations entre ces réponses, et donc à apprendre.

Montepare [Montepare, 2005] a mis au point une méthode d’auto-correction des QCM intéressante. Les QCM sont passés en utilisant des stylos d’une couleur donnée et, au lieu d’être corrigés tout de suite, les élèves s’engagent (seul ou collaborativement, le cas échéant avec le recours aux notes de cours et/ou manuels) dans une phase d’auto-correction où ils reprennent chaque item et déterminent si leur réponse était bien la bonne. S’ils estiment que non, ils signalent leur nouveau choix d’une autre couleur. Ensuite, l’enseignant corrige les QCM en attribuant le score de 1 si le choix initial était correct, de 0,5 si c’est le second choix qui était le bon, et de 0 dans les autres cas. L’auteur a remarqué un meilleur engagement de ses élèves avec cette méthode. Une expérimentation contrôlée des effets de cette méthode a récemment été réalisée et donne des résultats mitigés [Francis & Barnett, 2012].

Encadré 1 — Rétroactions immédiates ou retardées.

Essayons de comprendre pourquoi. Dans certains cas, des rétroactions immédiates peuvent à la fois être informantes, sans être profitables pour l’apprentissage. Il peut arriver, pour reprendre [Anonymous, 2016], qu’on donne des rétroactions immédiates à un apprenant et que cela puisse l’aider, à court terme, à se débrouiller dans son apprentissage ; mais il n’aura pas la possibilité de transférer cet apprentissage sur le long terme. La raison en est que les rétroactions ont un double effet : sur la motivation des apprenants (les rétroactions immédiates) et sur leur apprentissage (les rétroactions différées).

[Anonymous, 2016] utilise, pour faire comprendre ce paradoxe apparent, la métaphore suivante : utiliser un GPS pour se diriger dans une ville inconnue permet d’améliorer la performance immédiate (on arrive à se repérer), mais est peu opérant pour qu’on arrive, à plus long terme, à se repérer dans la ville. Dans ce dernier cas, une lecture de cartes seraient plus opérantes.

Ainsi, lorsque l’apprenant en est au début de l’apprentissage d’une notion, des rétroactions immédiates (de type GPS) sont utiles. Une fois qu’il progresse, des rétroactions retardées, résumant le travail accompli, seront plus utiles et le rendront moins dépendant de rétroactions immédiates.

L’apprentissage auto-régulé#

Jusqu’à présent, nous ne nous intéressions qu’aux systèmes analysant un choix d’élève parmi un ensemble de réponses possibles. En modifiant un peu l’utilisation standard de ce type de logiciels, il est également possible de favoriser l’ apprentissage auto-régulé des élèves, de la manière suivante :

en posant des questions déclenchant des auto-explications de compréhension, suite à la lecture d’un texte. Par exemple “Comment as-tu compris que X ?”, “Pourquoi sais-tu que Y?”, “Comment t’y prends-tu pour Z ?”

On peut même aller plus loin, et ajouter systématiquement de telles questions à la suite de QCM “traditionnels”. L’autre possibilité est d’afficher, au besoin (certains logiciels, comme eXe Learning, le permettent), un indice (“prompt”), qui oriente l’élève ayant des problèmes de compréhension de la question. Il peut s’agir d’une reformulation, d’un indice, d’une question permettant à l’élève de se réguler.

Quizz#

Pour aller plus loin#

Trouver d’autres avantages et d’autres inconvénients des QCM pour évaluer l’apprentissage. Aller sur la page wikipedia à propos des questionnaires à choix multiple. La recopier dans un fichier traitement de textes et l’améliorer en citant ses sources.

Lire l’un des manuels de construction de QCM cités en références.

Références#

- Anonymous, 2016(1,2)

None to claim their bones (2016). The feedback continuum: why reducing feedback helps students learn.

- Agarwal, 2019(1,2)

Agarwal, P. K. (2019). Retrieval practice & bloom's taxonomy: do students need fact knowledge before higher order learning? Journal of Educational Psychology, 111(2), 189-209. doi:10.1037/edu0000282

- Bangert-Drowns et al., 1991

Bangert-Drowns, R. L., Kulik, C., Kulik, J., & Morgan, M. T. (1991). The instructional effect of feedback in test-like events. Review of Educational Research, 61(2), 213–238.

- Bjork et al., 2014

Bjork, E. L., Little, J. L., & Storm, B. C. (2014). Multiple-choice testing as a desirable difficulty in the classroom. Journal of Applied Research in Memory and Cognition, 3, 165–170.

- Bleske-Rechek et al., 2007

Bleske-Rechek, A., Zeug, N., & Webb, R. M. (2007). Discrepant performance on multiple-choice and short answer assessments and the relation of performance to scholastic aptitude. Assessment & Evaluation in Higher Education, 32(2), 89–105.

- Bloom et al., 1969(1,2)

Bloom, B. S., Englehart, M. D., Furst, E. J., Hill, W. H., & Krathwohl, D. R. (1969). Taxonomie des objectifs pédagogiques. Vol. 1 : Domaine cognitif. Montréal: Education Nouvelle.

- Butler & Roediger, 2008(1,2)

Butler, A. C., & Roediger, H. L. (2008). Feedback enhances the positive effects and reduces the negative effects of multiple-choice testing. Memory & Cognition, 36(3), 604–616.

- Chen et al., 2017

Chen, O., Castro-Alonso, J. C., Paas, F., & Sweller, J. (2017). Extending cognitive load theory to incorporate working memory resource depletion: evidence from the spacing effect. Educational Psychology Review. doi:10.1007/s10648-017-9426-2

- Francis & Barnett, 2012

Francis, A. L., & Barnett, J. (2012). The effect and implications of a “self-correcting” assessment. Teaching of Psychology, 39(1), 38–41.

- Frederiksen, 1981(1,2)

Frederiksen, N. (1981). The real test bias. Educational Testing Service, report # RR-81-40.

- Jonsson et al., 2017

Jönsson, A., Rosenlund, D., & Alvén, F. (2017). Complement or contamination: a study of the validity of multiple-choice items when assessing reasoning skills in physics. Frontiers in Education, 2. doi:10.3389/feduc.2017.00048

- Latimier et al., 2019

Latimier, A., Riegert, A., Peyre, H., Ly, S. T., Casati, R., & Ramus, F. (2019). Does pre-testing promote better retention than post-testing? NPJ Sci Learn, 4, 15. URL: https://www.ncbi.nlm.nih.gov/pubmed/31583117, doi:10.1038/s41539-019-0053-1

- Leclercq, 2006

Leclercq, D. (2006). L'évolution des qcm. In G. Figari, & L. Mottier-Lopez (Eds.), Recherches sur l'évaluation en éducation (pp. 139–146). Paris: L'Harmattan.

- Marsh et al., 2007(1,2)

Marsh, E. J., Roediger, H. L., 3rd, Bjork, R. A., & Bjork, E. L. (2007). The memorial consequences of multiple-choice testing. Psychonomic Bulletin & Review, 14(2), 194–199.

- McDaniel et al., 2007

McDaniel, M. A., Anderson, J. L., Derbish, M. H., & Morrisette, N. (2007). Testing the testing effect in the classroom. European Journal of Cognitive Psychology, 19(4/5), 494–513.

- McDaniel et al., 2012

McDaniel, M. A., Wildman, K. M., & Anderson, J. L. (2012). Using quizzes to enhance summative-assessment performance in a web-based class: an experimental study. Journal of Applied Research in Memory and Cognition, 1, 18–26.

- Montepare, 2005

Montepare, J. M. (2005). A self-correcting approach to multiple choice tests.

- Rodriguez, 2003

Rodriguez, M. C. (2003). Construct equivalence of multiple-choice and constructed-response items: a random effects synthesis of correlations. Journal of Educational Measurement, 40(2), 163–184.

- Roediger & Butler, 2011(1,2)

Roediger, H. L., 3rd, & Butler, A. C. (2011). The critical role of retrieval practice in long-term retention. Trends in Cognitive Sciences, 15(1), 20–7.

- Roid & Haladyna, 1980(1,2)

Roid, G., & Haladyna, T. M. (1980). The emergence of an item-writing technology. Review of Educational Research, 50(2), 293–314.

- Sadler, 1999

Sadler, P. M. (1999). The relevance of multiple-choice tests in assessing science understanding. In J. J. Mintzes, J. H. Wandersee, & J. D. Novak (Eds.), Assessing science understanding: A human constructivist view (pp. 249–278). San Diego: Academic Press.

- Schmidt et al., 1998(1,2)

Schmidt, W. H., Jakwerth, P. M., & McKnight, C. C. (1998). Curriculum sensitive assessment: content does make a difference. International Journal of Educational Research, 29, 503–527.

- Shepard, 2008

Shepard, L. A. (2008). Commentary on the national mathematics advisory panel recommendations on assessment. Educational Researcher, 37(9), 602–609.

- Shermis & J, 2011

Shermis, M. D., & J., D. V. F. (2011). Classroom assessment in action. Lanham: Rowman & Littlefield.

- Sotola & Crede, 2020

Sotola, L. K., & Crede, M. (2020). Regarding class quizzes: a meta-analytic synthesis of studies on the relationship between frequent low-stakes testing and class performance. Educational Psychology Review. doi:10.1007/s10648-020-09563-9

- Szpunar et al., 2013

Szpunar, K. K., Khan, N. Y., & Schacter, D. L. (2013). Interpolated memory tests reduce mind wandering and improve learning of online lectures. Proc. Natl. Acad. Sci. U.S.A., 110(16), 6313-7. URL: https://www.ncbi.nlm.nih.gov/pubmed/23576743, doi:10.1073/pnas.1221764110

- Tractenberg et al., 2013

Tractenberg, R. E., Gushta, M. M., Mulroney, S. E., & Weissinger, P. A. (2013). Multiple choice questions can be designed or revised to challenge learners' critical thinking. Advances in Health Sciences Education, 18(5), 945–961.

- Gog & Sweller, 2015

van Gog, T., & Sweller, J. (2015). Not new, but nearly forgotten: the testing effect decreases or even disappears as the complexity of learning materials increases. Educational Psychology Review, 27(2), 247-264. doi:10.1007/s10648-015-9310-x

- Williams, 2006

Williams, J. B. (2006). Assertion-reason multiple-choice testing as a tool for deep learning: a qualitative analysis. Assessment & Evaluation in Higher Education, 31(3), 287–301.