Comprendre les méta-analyses#

Information

Auteur : Philippe Dessus, Inspé & LaRAC, Univ. Grenoble Alpes, & Ignacio Atal, Learning Planet Institute, Univ. Paris Cité.

Date de création : Janvier 2024.

Résumé : Ce Document présente quelques éléments pour comprendre ce qu’est une méta-analyse.

Voir aussi : L’éducation fondée par les preuves et L’apprentissage visible : qu’est-ce qui marche en éducation ?.

Introduction#

L’émergence du courant de l’éducation fondée sur des données probantes (plus d’informations dans le Document L’éducation fondée par les preuves) a fait augmenter l’intérêt pour des travaux expérimentaux mettant en évidence des relations de cause à effet entre des interventions éducatives et les performances scolaires au sens large (incluant donc autant les performances académiques que des résultats, par exemple, en termes de bien-être, de motivation, ou de réduction du harcèlement). Cela a entraîné, d’une part, une centration sur des essais contrôlés aléatorisés (randomized controlled trials) et, d’autre part, une centration sur des synthèses, censées résumer les résultats de plusieurs études individuelles. Le reste de ce document va s’intéresser à un type de ces synthèses, les méta-analyses (nous évoquerons brièvement les revues systématiques).

La méta-analyse est une méthode de recherche quantitative qui agrège de manière standardisée de nombreux résultats d’études différentes mais au sein desquelles des données recueillies permettent de répondre à une même question de recherche : ”est-ce que la variable x (souvent appelée intervention) a un effet sur une variable y (souvent appelée “outcome”, ou résultat) ?” et permettant de déterminer la taille (grandeur) de cet effet. La taille de l’effet mesure la différence standardisée entre deux groupes : celui qui a reçu une intervention expérimentale et celui qui n’en a pas reçu (groupe-contrôle).

Cette méthode (voir [Wanlin, 2019]) ne recourt pas à une analyse primaire de données (i.e., analyser des données au niveau élève suite à leur recueil), ni même secondaire (i.e., analyser les mêmes données au niveau élève avec d’autres méthodes) ; c’est une analyse d’analyses. Toutefois, lorsque les données primaires de plusieurs études sont directement accessibles, ce qui est le cas en médecine, il est possible de réaliser des méta-analyses directement à partir de ces données primaires.

Notons aussi que la méta-analyse peut permettre d’estimer les effets d’une intervention sur différents outcomes : par exemple, plutôt que de parler d’apprentissage au sens large, on pourra détailler les effets différenciés des interventions sur la mémorisation, la reconnaissance, ou le transfert de connaissances.

Le principal avantage de cette méthode est qu’elle permet de gagner en puissance statistique : on agrège des données d’études qui, individuellement, utilisaient des tests qui n’avaient pas nécessairement une puissance statistique suffisante pour répondre à la question. D’autre part, elle permet d’avoir une vue globale et exhaustive sur une question de recherche. C’est une pratique maintenant courante et l’on trouve des méta-analyses sur la plupart des questions en éducation ; il existe même des journaux quasi-exclusivement dédiés aux méta-analyses dans ce domaine (e.g., la Review of Educational Research et l’Educational Research Review.

Il ne faut pas confondre une méta-analyse avec des formes de méthodes proches, comme la revue systématique, qui est une recension systématique et exhaustive d’un ensemble de résultats de recherches sur un thème donné, mais sans calcul synthétique de taille d’effet.

Les étapes d’une méta-analyse#

Voici quelles sont les principales étapes d’une méta-analyse (ce qui suit est inspiré de [Wanlin, 2019]) :

Définir le problème : Quelle est la question de recherche posée, par exemple : quels sont les effets du redoublement sur la performance en apprentissage des élèves de niveau n ? Notons que si la performance, en recherche en éducation, est souvent une variable d’intérêt, il peut bien sûr y en avoir d’autres (p. ex., la motivation, l’engagement, etc.).

Collecter la littérature sur ce problème : Il s’agit ensuite d’identifier et collecter les travaux (articles, livres, rapports) qui contiennent des recherches primaires répondant au problème posé. Cette étape doit être la plus systématique possible pour viser à l’exhaustivité, et doit être décrite précisément, de manière à ce qu’on puisse la comprendre, la reproduire, et la critiquer. On précisera par exemple les travaux choisis et exclus à chaque étape de la collecte. On conduit des recherches dans des bases d’articles (Google Scholar est un accès à la plupart des bases d’articles) en notant précisément les requêtes utilisées ; la langue anglaise est privilégiée, sauf bien sûr si on se focalise sur les recherches écrites dans une autre langue. Pour éviter le biais de publication (seules les études ayant conduit à des résultats statistiquement significatifs sont publiées), les requêtes peuvent aussi porter sur les rapports de recherche non publiés dans des revues. Par exemple, on peut choisir de sélectionner uniquement des études RCT (randomisées et contrôlées). Notons enfin que cette étape de sélection est préférablement réalisée en double aveugle.

Coder les résultats : Une fois que les travaux ont été sélectionnés, il faut coder quantitativement et de manière standardisée les caractéristiques des études qui peuvent jouer un rôle dans les variables recueillies. Le cadre PICO, pour Population de l’étude, Intervention expérimentée, le Comparateur, et l’Outcome utilisé pour juger de l’efficacité de l’intervention est souvent utilisé dans cette étape.

Transformer les résultats en tailles d’effet : Comme les résultats de chaque étude peuvent avoir été calculés de manière non comparable, il est nécessaire de procéder à un recalcul standardisé des résultats pertinents. Le format comparable choisi est souvent la taille d’effet, mais peut être également la corrélation. Nous reviendrons sur ces points dans une prochaine section.

Analyser statistiquement les résultats : Cette phase est dédiée à creuser l’effet particulier des caractéristiques en jeu, afin de comprendre celles qui ont un rôle central dans la taille d’effet. Le but de cette phase est de ne pas s’attarder sur la taille d’effet moyenne, mais d’identifier les caractéristiques contextuelles de l’intervention ou de la population étudiée, qui peuvent affecter la taille d’effet.

La taille de l’effet#

La taille de l’effet est définie comme la différence de performances entre deux groupes en unités d’écart-type (d de Cohen). Un d de 1 signale que la performance moyenne du groupe-contrôle est un écart-type inférieure à celle du groupe expérimental. Si les performances des deux groupes suivent une distribution normale, cela signifie que le score d’une personne moyenne du groupe expérimental est supérieur ou égal à 84 % des personnes du groupe-contrôle, ou, bien sûr, à 1 écart-type au-dessus. Bien évidemment, un d négatif signale que le groupe-contrôle a de meilleures performances moyennes que le groupe expérimental. Le site de Magnusson donne une visualisation interactive du d de Cohen.

Cette valeur permet une comparaison standardisée entre études ayant des variables dépendantes mesurées avec des échelles différentes. On retrouve ainsi un d de Cohen au niveau de chaque étude, mais aussi au niveau d’une meta-analyse, suite à l’agrégation des d de Cohen de chaque étude, les études avec un échantillon plus faible ayant moins de poids dans l’agrégation que les études avec un grand échantillon.

Une question importante est de pouvoir interpréter la taille de l’effet : quelles sont les valeurs de seuil d’un effet “grand” ? petit ? Les interprétations varient selon les auteurs, les contextes d’étude, et les indices calculés. Cohen signale qu’un effet est considéré comme grand au-delà de 0,8, moyen entre 0,5 et 0,8, et petit entre 0 et 0,2.

Mais il faut noter deux choses. Premièrement, la taille de l’effet d’une intervention n’est pas la même chose que ses conséquences : une taille d’effet, même très petite, peut avoir des implications pratiques importantes dans certains cas (un effet, même faible, d’une intervention destinée à prévenir les suicides, serait déjà tout à fait souhaitable, voir Lakens, 2022). De la même façon, le contexte des études peut avoir une forte influence sur la valeur de la taille d’effet. Par exemple, une étude évaluant l’efficacité sur les performances scolaires d’une activité de formation auprès d’enseignants pour adopter la pratique X aura un d de Cohen systématiquement plus faible qu’une étude visant à évaluer directement l’efficacité de la pratique X dans les performances scolaires. Il est d’ailleurs rare de trouver des d de Cohen supérieurs à 0,2 dans les évaluations de programmes de développement professionnel des enseignants, mais cela n’empêche pas que de tels programmes soient intéressants car ils permettent de déployer une pratique efficace à l’échelle [Sims et al., 2021].

Deuxièmement, le terme “effet” prête à confusion, car il laisse supposer qu’une relation de cause à effet entre la variable x et y existe de fait, alors qu’elle n’est effectivement mise au jour, au niveau de la méta-analyse, que si l’on n’y intègre que des essais contrôlés aléatorisés (RCT), ce qui est loin d’être toujours le cas (voir [Kraft, 2020]).

Les intérêts des méta-analyses#

Les méta-analyses ont pour but d’agréger un grand nombre de résultats d’études primaires. Cela peut être tout à fait utile de s’y référer quand on commence à défricher un champ de recherche, ou bien lorsque les résultats d’un champ paraissent contradictoires.

Pour cette raison, il est conseillé de rechercher les méta-analyses (ou revues systématiques) reliées à son problème de recherche, pour avoir une vue synthétique et générale ; mais aussi pour voir ce qui marche, ce qui a été beaucoup ou peu testé, etc.

Interpréter les résultats des méta-analyses#

Il convient d’étudier de près le comparateur des études : à quoi sont comparées les études expérimentales ? un groupe-contrôle sans intervention ? un autre type d’intervention ? Il est également préférable, dans la lecture de méta-analyses, de se restreindre à l’étude d’un seul outcome et de relever les tailles des effets de chaque intervention ciblant cet outcome. Se centrer sur un niveau de population (p. ex., 1er ou 2d degré) est également utile.

On peut aussi noter que les personnes d’un groupe-contrôle, donc sans participer à aucune intervention spécifique, ont des performances qui augmentent dans le temps, et que ces augmentations vont être plus ou moins élevées en fonction du niveau de développement des élèves. Par exemple, entre le CM1 et CM2, la taille d’effet de la progression en lecture d’un élève états-unien moyen est de 0,30 [source], elle est de 0,52 entre le CE2 et CM1 en maths [Kraft, 2020]. L’EEF indique, dans ses méta-analyses, le nombre de mois de progrès supplémentaires induits par l’intervention étudiée (par exemple, procurer des rétroactions aux apprenants a un impact moyen de six mois de progrès, ce qui correspond à une taille d’effet entre 0,45 et 0,52). Il est donc pertinent, au moment d’interpréter une taille d’effet, de comparer avec l’évolution moyenne des élèves de cette tranche d’âge sur l’outcome d’intérêt.

Ensuite, la taille de l’effet varie selon le type d’outcomes étudiés [Kraft, 2020]. Lorsque ces derniers sont aisés à changer, fondés sur des mesures précises et mesurés juste après l’intervention, ils induisent des tailles d’effet plus importantes que celles fondées sur des outcomes sur lesquels il est plus difficile d’agir, mesurés à plus long terme et avec des tests moins spécialisés. Il est donc très difficile de comparer les tailles d’effets dans des méga-analyses, ou même dans des meta-analyses incluant des études qui mesurent les outcomes à des temporalités différentes. Il vaut mieux éviter de le faire.

Enfin, on ne devrait soupeser l’effet d’une intervention qu’en ayant aussi à l’esprit son coût. À niveau d’effet presque équivalent, l’intervention la plus aisée à mettre en place et la moins chère devrait être privilégiée [Kraft, 2020].

Critiques des méta-analyses#

Les principales critiques sur les méta-analyses sont les suivantes.

La première critique a été d’amener la focalisation sur une valeur (la taille d’effet) pour juger de l’efficacité d’une intervention, presque indépendamment d’autres éléments de contexte. Or, qui voudrait d’une intervention efficace (les élèves apprendraient effectivement), mais qui en même temps enlèverait tout intérêt des élèves pour la matière ? (voir http://zhaolearning.com/2018/10/07/what-evidence-problems-with-evidence-based-education-side-effects-in-education/) ; Voir Zhao, et l’effet mentos-cola https://theeconomyofmeaning.com/2022/12/15/the-positive-effects-of-universal-design-for-learning-on-learning-meta-analysis/

La qualité de la méta-analyse ne peut être supérieure à celle des études qui la composent (comme le dit l’adage : garbage in, garbage out). En d’autres termes, si la phase de sélection des études est mal réalisée, avec des critères de choix insuffisamment précis, la sélection va comporter des études trop hétérogènes pour être comparables, et donc introduire des biais. Un autre biais lié à la qualité des études sélectionnées est celui des pratiques de recherche non-éthiques, “questionnables”, ou méthodologiquement faibles, où les chercheurs, soit ont triché pour avoir des résultats significatifs (par exemple, en supprimant des données, en choisissant une variable dépendante au détriment d’une autre), soit utilisent des méthodes d’analyse qui ne correspondent pas ou plus aux canons modernes (voir [Kraft, 2020]).

Un point qui n’est pas relié aux méta-analyses en tant que telles, mais au compilations de méta-analyses, est que ces dernières mélangent trop facilement les pommes et les poires. Cela est particulièrement le cas pour un type de méta-analyses : les méta-méta-analyses (ou méga-analyses), qui sont des agrégations de méta-analyses (voir notamment les célèbres travaux de Hattie). Nous avons vu plus haut que les tailles d’effet variaient en fonction de paramètres non directement reliés à la qualité de l’intervention ; il faut donc considérer les méga-analyses avec la plus grande prudence.

Les revues systématiques#

Les revues systématiques (systematic reviews) sont construites de manière assez similaire aux méta-analyses : les 3 premières phases sont assez semblables, mais les suivantes sont réalisées d’un point de vue qualitatif, donc sans calcul de taille d’effet.

Un exemple de lecture#

Contexte#

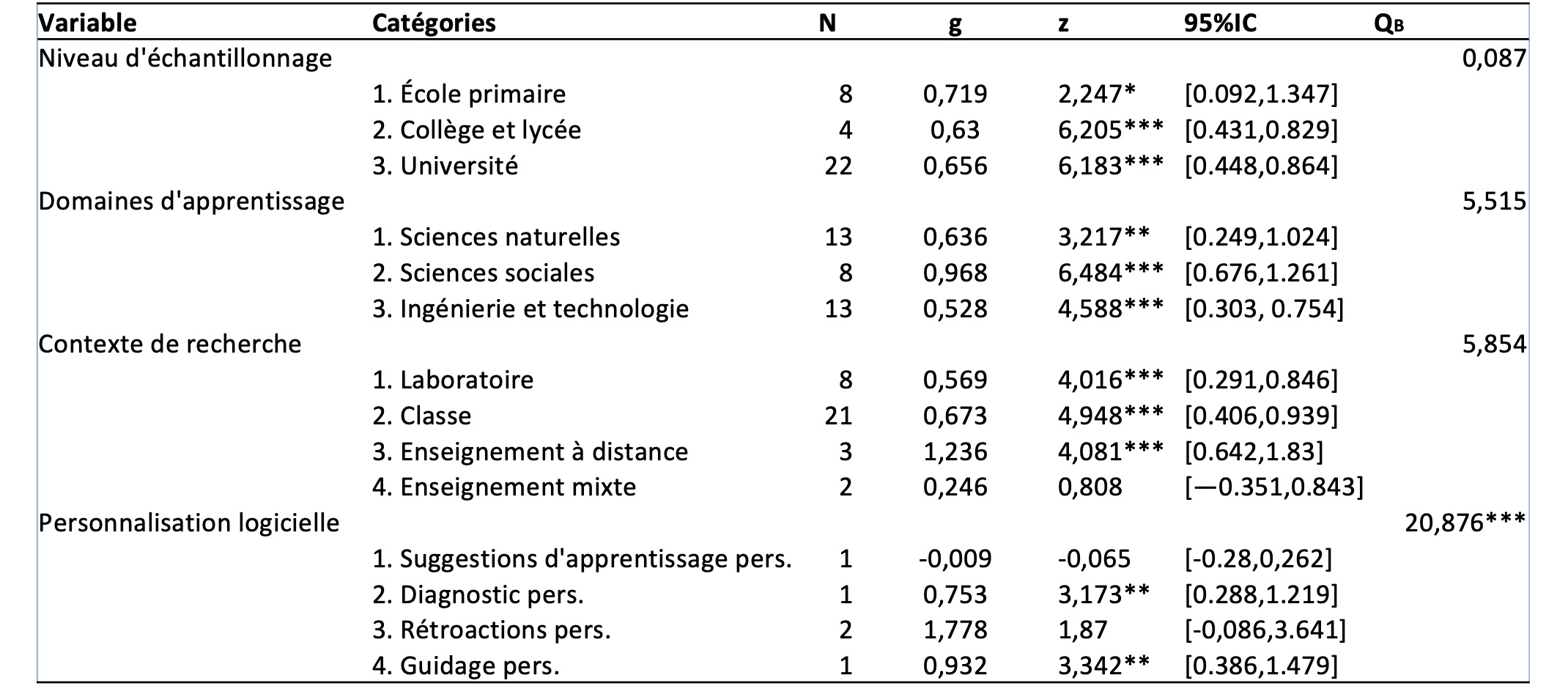

L’utilisation du numérique est souvent vue comme un moyen de “personnaliser l’apprentissage”, en fonction des besoins, buts et compétences des apprenants. La méta-analyse de Zheng et al. (2022) synthétise les résultats de 34 études réalisées entre 2001 et 2020 en étudiant leur effet sur l’apprentissage des participants (élèves ou étudiants). Le tableau ci-dessous reprend quelques résultats de l’étude.

Figure 11 Caractéristiques principales des effets de quelques variables sur l’apprentissage des élèves et étudiants - Source : Zheng, L., Long, M., Zhong, L., & Gyasi, J. F. (2022). The effectiveness of technology-facilitated personalized learning on learning achievements and learning perceptions: a meta-analysis. Education and Information Technologies. https://doi.org/10.1007/s10639-022-11092-7

Voici une explication des termes utilisés :

N : indique le nombre d’études impliquées dans le calcul des tailles d’effets de chaque variable

g : indique la taille d’effet (le g de Hedges est comparable au d de Cohen)

95%IC : indique l’intervalle de confiance à 95 %, soit la variabilité de la taille d’effet. En d’autres termes, pour 100 tirages aléatoires d’échantillons d’élèves ayant réalisé l’étude, 95 auraient une taille d’effet dans l’intervalle donné. Donc, plus cet intervalle est réduit, plus la variabilité est faible, d’une part, et d’autre part, si cet intervalle ne contient pas 0, cela signifie que l’effet est significatif avec un p < 0,05.

Niveau d’échantillonnage : Les résultats indiquent que les études d’apprentissage personnalisé mises en œuvre dans les écoles primaires ont généré l’effet le plus important sur l’apprentissage, suivies par les établissements d’enseignement supérieur, les collèges et les lycées. Néanmoins, le QB n’a pas atteint la signification statistique. Par conséquent, il n’y avait pas de différences significatives dans les tailles d’effet entre les différents niveaux et tailles d’échantillons.

Domaines d’apprentissage : Les sciences sociales ont la taille d’effet la plus importante, suivies par les sciences naturelles, l’ingénierie et les sciences techniques. Cependant, le QB n’a pas atteint la signification statistique, ce qui indique qu’il n’y a pas de différence significative dans l’ampleur de l’effet entre les différents domaines d’apprentissage.

Contexte de recherche : En ce qui concerne les contextes de recherche, les contextes d’apprentissage en ligne présentent la taille d’effet la plus importante, suivis par les contextes d’apprentissage en classe, en laboratoire et mixte. Néanmoins, le QB n’a pas atteint la signification statistique, ce qui implique qu’il n’y a pas de différence significative de taille d’effet entre les différents contextes de recherche.

Personnalisation logicielle : Les rétroactions personnalisées avaient la taille d’effet la plus importante, suivies par le guidage personnalisé, le diagnostic personnalisé, et les suggestions d’apprentissage personnalisé. Le test d’hétérogénéité a montré que la taille d’effet moyenne des différents types de logiciels soutenant l’apprentissage personnalisé différait de manière significative (QB=20,876, df=5, p=.001). Toutefois, il convient d’interpréter ce résultat avec précaution, tant le nombre d’études impliquées est faible (5 en tout).

Des sites compilant des méta-analyses

Webographie

Education Endowment Foundation (2018). Sutton Trust-EEF Teaching and Learning Toolkit. Durham: Durham Univ., accédé le 10 juillet 2022 à https://educationendowmentfoundation.org.uk/public/files/Toolkit/Toolkit_Manual_2018.pdf

Harrer, M., Cuijpers, P., Furukawa, T.A., & Ebert, D.D. (2021). Doing Meta-Analysis with R: A Hands-On Guide. Boca Raton, FL and London: Chapman & Hall/CRC Press. ISBN 978-0-367-61007-4.

Jané, M. B. et al. (2024). Guide to effect sizes and confidence intervals.

Lakens, D. (2022). Improving Your Statistical Inferences. Retrieved from https://lakens.github.io/statistical_inferences/. https://doi.org/10.5281/zenodo.6409077

Références

- Kraft, 2020(1,2,3,4,5)

Kraft, M. A. (2020). Interpreting effect sizes of education interventions. Educational Researcher, 49(4), 241-253. doi:10.3102/0013189x20912798

- Sims et al., 2021

Sims, S., Fletcher-Wood, H., O’Mara-Eves, A., Cottingham, S., Stansfield, C., Van Herwegen, J., & Anders, J. (2021). What are the characteristics of effective teacher professional development? A Systematic review and meta-analysis. Education Endowment Foundation.

- Wanlin, 2019(1,2)

Wanlin, P. (2019). L'approche méta-analytique : comment ça marche, comment comprendre ses outputs.