Le design centré sur les valeurs de systèmes pour l’éducation fondés sur l’IA#

Informations

Auteurs : Philippe Dessus, Inspé & LaRAC, Univ. Grenoble Alpes.

Date de création : Juin 2023.

Résumé : Ce document présente une démarche méthodique pour mettre au jour les valeurs éthiques dans la conception d’un système utilisant l’intelligence artificielle pour l’éducation. Cette démarche est illustrée par un exemple en fin de document.

Voir aussi : Les Documents gene:concevoir_enseignement et Concevoir des usages du numérique par la scénarisation.

Introduction#

Sommairement, on peut distinguer deux grands champs d’application de l’IA en éducation (dorénavant, IAED)[CalvetLinan & JuanPerez, 2015].

Les Learning Analytics (analytique de l’apprentissage) : centrés sur les visualisations des données, les données en temps réel, pour informer ses utilisateurs, enseignants et apprenants, sur leur activité ;

L’Educational Data Mining (fouille de données éducatives) : analysant les nombreuses données issues de traces de l’apprentissage pour générer des décisions pédagogiques automatiques (tutorat automatique, rétroactions, etc.), la plupart du temps réalisées a posteriori.

Travailler dans ces deux domaines implique la saisie et l’analyse de grands corpus de données (de traces, de performances d’apprenants, voire d’enseignants) et, en retour, des rétroactions ou informations plus ou moins agrégées sur ces données, délivrées aux participant·es ou aux chercheur·es.

Les données (notamment, de traces) recueillies et analysées pour ces deux grands types de buts ont donc une valeur économique puisque les systèmes peuvent être, in fine, commercialisés. Elles doivent aussi, que ce soit au niveau du recueil, de l’analyse ou de la restitution de rétroactions, respecter des valeurs humaines, c’est-à-dire ce que l’on peut considérer comme important dans la vie (par exemple, la solidarité, la communication, le respect de la personne…). Cela nous amène à considérer les aspects éthiques de la collecte et l’utilisation de ces données, éthique valant pour une “théorie des valeurs” ([Friedman et al., 2008] p. 70).

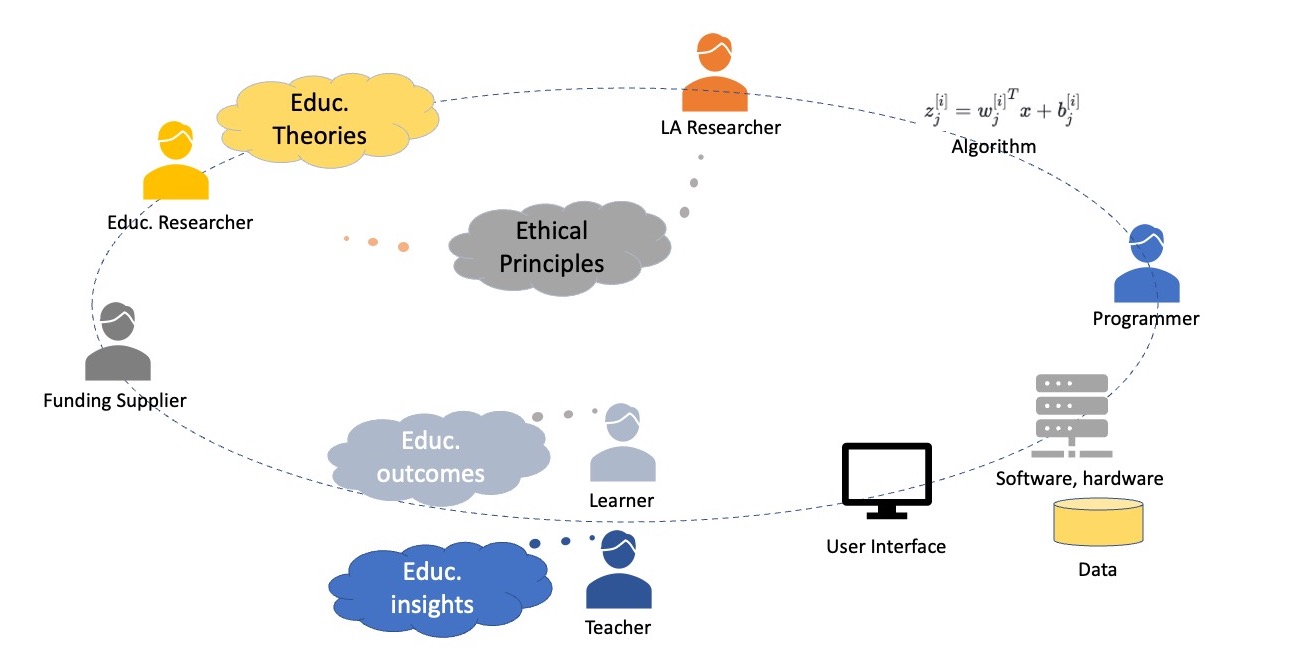

La Figure 1 ci-dessous, d’après [BuckinghamShum, 2017], représente le circuit de l’information et de conception des dispositifs (du système, de la recherche) en lien avec l’IAED. Il commence par le financeur, qui décide de financer un projet soumis conjointement par le chercheur en éducation et en Learning Analytics (LA). Une ou des technique·s d’analyse des données sont déterminées, en fonction de théories de l’éducation, mais aussi de principes éthiques, ainsi qu’une interface-utilisateur qu’enseignants et apprenants peuvent utiliser, selon les buts du système. Si les principes éthiques ne paraissent concerner que les chercheurs, il est assez probable qu’en réalité ils concernent aussi le programmeur, les enseignants et apprenants.

Ici, nous allons principalement évoquer les systèmes IAED dans l’enseignement supérieur (où les apprenants sont des étudiants), mais la démarche explicitée ci-après vaut également pour d’autres contextes d’enseignement (primaire et secondaire).

Figure 1 – Représentation graphique du flux d’information pendant la conception et le test d’un IAED [BuckinghamShum, 2017].

Il y a de très nombreux champs auxquels attribuer, et discuter, de la valeur, notamment, d’une technologie [Friedman et al., 2008] : la vie privée, la propriété, le bien-être physique et mental, être préservés de biais, l’accessibilité universelle, l’autonomie, le consentement éclairé… Et ces champs se multiplient quand on s’intéresse au développement d’une technologie dans un contexte de recherche. Par exemple le Tableau 6 d’Elliott ([Elliott, 2022], p. 52), qui sera augmenté et présenté dans le Tableau II ci-après, liste de très nombreuses sortes de règles pour une bonne pratique scientifique : responsabilité sociale, définition de ce que sont des mauvaises conduites scientifiques, un design d’expérimentation, des méthodes d’analyse de données (statistiques) appropriées, l’accès aux données, la gestion des conflits d’intérêts dans les soumissions et relectures des appels de recherche, le partage des données, etc.

[Frank et al., 2023] considèrent trois différents cadres dans lesquels penser l’éthique :

Le cadre conséquentialiste, toujours selon ces auteurs, signale que des théories éthiques donnent des principes desquels découlent de bonnes actions, elles-mêmes amenant de bons résultats. Dans ce cadre, une évaluation éthique amène à peser les conséquences positives d’une action et de les comparer à ses conséquences négatives. Par exemple, le problème du trolley est souvent présenté de manière conséquentialiste : vaut-il mieux sacrifier la vie d’une personne (en la poussant sur les rails) ou de plusieurs, en laissant le trolley continuer sa route ?

Le cadre déontologique, dans lequel est mis en avant l’importance de prendre des décisions menant à des actions permises par un code déontologique et des principes fixés par avance (très souvent les suivants : autonomie des participants, faire le bien, ne pas faire le mal, justice), quelles qu’en soient les conséquences. Les comités d’éthique délivrant les IRB (International Review Board) fonctionnent dans ce cadre.

Le cadre des vertus (virtue), fonctionne sur le principe que pour se comporter de manière éthique, on va se comporter de la même manière que ceux que l’on admire, et qui se comportent eux-mêmes de manière éthique. Ce comportement sera renforcé puisque ces personnes vont être gratifiées par ce comportement au cours de leurs actions. Ce cadre amène à évaluer régulièrement l’état mental des participants pour être sûr que leurs principes ne les amènent pas à faire des actions inacceptables.

Au-delà de ces cadres, nous allons ici nous intéresser à ce qui, du contexte éducatif, est capturé par les systèmes, et le type de données qui sont collectées et analysées pour le caractériser, et les implications éthiques de ces captures, collectes et analyses. Cela afin d’en dériver une série de règles éthiques.

La suite de ce document va présenter une méthode de réflexion et de spécification des valeurs liées à un système IAED, pouvant être suivie par des enseignants et des chercheurs. Cette méthode, inspirée des travaux de Friedman et ses collègues (pour l’aspect de design) et d’Elliott (pour sa réflexion sur les valeurs), est articulée dans les étapes suivantes :

Les règles éthiques et l’éducation

Identifier les utilisateurs directs et indirects

Bénéfices et inconvénients des utilisateurs

Valeurs et tensions entre les valeurs

Replacer les valeurs dans les différentes phases de la recherche

Une méthode pour penser les valeurs en IAED#

Les règles éthiques et les buts en éducation#

Il existe de très nombreuses normes éthiques (donc partant d’une approche déontologique), et encore plus de valeurs auxquelles la science (et l’IAED en particulier) doit/peut suivre ou se conformer mais il est difficile de les lister toutes, elles sont formulées généralement et leur applicabilité demande souvent une formulation plus précise, et certaines peuvent avoir des effets contraires à d’autres, notamment dans les cas complexes [Elliott, 2022, Friedman et al., 2008]. Un des problèmes rencontrés dans les recherches en IAED est qu’elles n’étudient que très rarement le point de rencontre spécifique entre l’IA et l’éducation et qu’elles s’intéressent presque exclusivement aux données, et moins aux conséquences, notamment sociales, de leur traitement [Holmes et al., 2021]. Dans notre cas, l’éducation est une activité et un contexte spécifiques, qui amènent des considérations éthiques spécifiques.

L’éducation charrie en soi des aspects normatifs [Peters, 1966]. Comme l’indique ce dernier : « Ce serait une contradiction logique de dire qu’un homme a été éduqué mais qu’il n’a en aucune manière changé en mieux, or qu’en éduquant son fils un homme n’essayait rien qui ne soit digne d’intérêt » (id., p. 25). De nombreux auteurs ont essayé de synthétiser les rôles de l’éducation. [Biesta, 2020, Egan, 1997] s’accordent sur les trois buts suivants (l’ordre n’est pas significatif) :

socialiser les élèves et étudiants, où l’on fait en sorte qu’ils soient intégrés aux pratiques culturelles et sociales de leur environnement, qu’il soit scolaire ou familial, mais aussi (et surtout dans le supérieur), qu’ils puissent s’intégrer dans un milieu professionnel futur ;

les confronter à des savoirs objectifs sur le monde, où l’on fait en sorte de présenter aux élèves et étudiants des savoirs et pratiques objectifs qui les amèneront à développer des connaissances et compétences ;

aider leur développement individuel, où l’on fait en sorte que les élèves et étudiants s’émancipent, deviennent des sujets libres et conscients de leurs choix dans la société, et se réalisent suivant leurs propres potentialités.

Egan a montré que ces trois buts étaient incompatibles deux à deux voir [Dessus, 2003] pour une explication. Il est impossible de lister toutes les valeurs éducatives qu’on peut poursuivre car elles dépendent du niveau d’enseignement, des matières et des visées personnelles des enseignants. Nous pouvons nous demander dans quelle mesure, et avec quels effets, les systèmes IAED développés peuvent, soit concourir à développer ces buts, soit les gêner, conjointement ou séparément. Par exemple, un croisement avec le classement des systèmes IAED de [Holmes & Tuomi, 2022] permet de pointer les rôles éducatifs prépondérants de chaque système, reportés dans le Tableau I ci-dessous.

Le premier travail, pour toute personne conceptrice d’IAED, est donc de réfléchir au but éducatif principal qu’elle veut que son système promeuve, tout en étant attentive à de possibles contradictions entre buts, s’il en promeut plusieurs.

Tableau I — Typologie de logiciels et leurs effets sur l’éducation (classification d’après [Holmes & Tuomi, 2022]). Un + signale un effet positif possible ; un – signale un effet négatif possible ; un “?” signale un effet indéterminé.

Socialiser |

Savoirs objectifs |

Dév. individuel |

|

|---|---|---|---|

Systèmes centrés sur les étudiants |

|||

Systèmes tuteurs intelligents (Intelligent Tutoring Systems, ITS) |

+ |

||

Simulations assistées par l’IA (jeux, réalités virtuelles ou augmentées) |

+ |

+ |

+ |

Écriture automatique d’essais |

+ |

||

Évaluation formative automatique |

+ |

+ |

|

Tuteurs fondés sur le dialogue |

+ |

+ |

|

Assistant d’apprentissage tout au long de la vie utilisant l’IA |

+ |

+ |

|

Applications utilisant de l’IA (e.g., maths, reconnaissance de parole, apprentissage de langues) |

+ |

||

Aider les apprenants à besoins spécifiques avec l’IA |

+ |

||

Agents conversationnels (Chatbots) |

+ |

+ |

|

Orchestration de réseaux d’apprentissage |

+ |

||

Environnements d’apprentissage fondés sur l’exploration |

+ |

+ |

+ |

Systèmes centrés sur les enseignants |

|||

Détection de plagiat |

– |

||

Monitorage de cours |

– |

||

Assistant d’enseignement fondé sur l’IA (e.g., assistant d’évaluation) |

+ |

||

Planification de cours, agenda, allocation horaire |

? |

? |

? |

Identification des abandons et des étudiants à risque |

+ |

+ |

|

Curation intelligente de matériels d’apprentissage |

+ |

||

Évaluation sommative automatique |

+ |

||

Orchestration de cours |

|||

Systèmes centrés sur l’administration |

|||

Gestion des admissions des élèves (e.g., sélection des élèves) |

|||

Sécurité des écoles et établissements |

+ |

||

Surveillance à distance des examens (proctoring) |

– |

Identification des utilisateurs directs et indirects#

Ce qui suit reprend de plus près la méthode “Value sensitive design” de [Friedman et al., 2008]. Une fois le but éducatif en tête, il va être tout d’abord utile d’identifier deux types d’utilisateurs ciblés par le système IAED : les utilisateurs directs qui interagissent directement avec le système ou ses sorties, et les utilisateurs indirects, qui peuvent être affectés par l’utilisation du système, sans qu’ils interagissent directement avec lui [Friedman et al., 2008].

Enseignants et étudiants sont souvent des utilisateurs directs d’un système IAED, et le personnel administratif ou technique d’un établissement est souvent considéré comme des utilisateurs indirects puisqu’ils peuvent aider les participants directs à utiliser le système, sauf dans le cas de systèmes centrés sur des tâches administratives (comme l’admission ou la sélection d’étudiants, la conception d’emplois du temps, la gestion des notes, etc.). Les financeurs sont dans la plupart des cas des utilisateurs indirects.

Bénéfices et inconvénients des utilisateurs#

Pour chaque groupe d’utilisateurs, il est possible de déterminer leur bénéfices et pertes à l’utilisation du système, et les valeurs qui y sont reliées (ce qui est important pour eux, dans leur vie, et leur pratique dans le contexte d’utilisation du système).

Par exemple, les étudiants utilisant une plate-forme d’enseignement à distance gagnent la possibilité d’un guichet unique pour accéder à la fois à un ensemble de cours et le moyen de livrer leurs travaux pour en récupérer des rétroactions ; ils perdent une certaine autonomie, puisque leurs accès dans la plate-forme peuvent-être aisément tracés. Dans la même utilisation, les enseignants gagnent avec ces plates-formes la facilité de récupérer les travaux des étudiants en temps et en heure, ils perdent en revanche une certaine liberté pédagogique puisque le choix de la plate-forme est en général imposé.

Valeurs et tensions entre valeurs#

On peut ensuite spécifier les valeurs les plus saillantes du système utilisé, et d’étudier et diagnostiquer, dans un second temps, les possibles tensions entre elles. Il est parfois difficile d’identifier les limites entre valeurs, également. Satisfaire une valeur particulière se fait souvent au détriment d’une autre. [Friedman et al., 2008] (p. 89) citent les dilemmes suivants : “responsabilisation” (accountability) vs. prise en compte de la vie privée, développement durable vs. développement économique, etc. À ce sujet, [Floridi et al., 2018] (p. 691) proposent les 4 opportunités vs. risques suivants :

Permettre l’auto-réalisation humaine <-> Dévaluer les habiletés humaines

Augmenter le pouvoir d’agir humain (agency) <-> Supprimer ou amoindrir les responsabilités humaines

Augmenter les capacités sociales <-> Réduire le contrôle humain

Cultiver la cohésion sociale <-> Éroder l’auto-détermination humaine.

Replacer les valeurs dans les différentes phases de la recherche#

L’éthique en IAED est spécialement importante (comme elle l’est pour la santé par exemple) car l’éducation est un moyen d’améliorer les inégalités d’accès à la connaissance et donc la mobilité sociale [Bartoletti, 2023]. Pour l’instant, et comme nous l’avons déjà mentionné, il y a plutôt une centration sur les données et sur comment elles sont traitées, plus que sur l’impact de l’IA sur les processus d’éducation, ou leur co-évolution [Holmes et al., 2021]. Il y a déjà les larges recensions des nombreuses règles de conduite éthiques produites [Floridi et al., 2018, Hagendorff, 2020, Jobin et al., 2019]}, tournant majoritairement autour de trois principes généraux : responsabilité (accountability), respect de la vie privée (privacy), et équité (fairness).

Plutôt que de formuler des règles éthiques générales, qui ne valent que pour une phase de la recherche, nous avons opté pour distinguer quatre phases principales dans la recherche en IAED et de formuler, dans chacune de ces phases, des questions spécifiques sur les valeurs. Ce point est très important car il permet d’éviter les « points aveugles », c’est-à-dire des principes non discutés dans les guides éthiques sur l’IA [Hagendorff, 2020], comme par exemple celui du financement de la recherche en IA par partenariats public-privé.

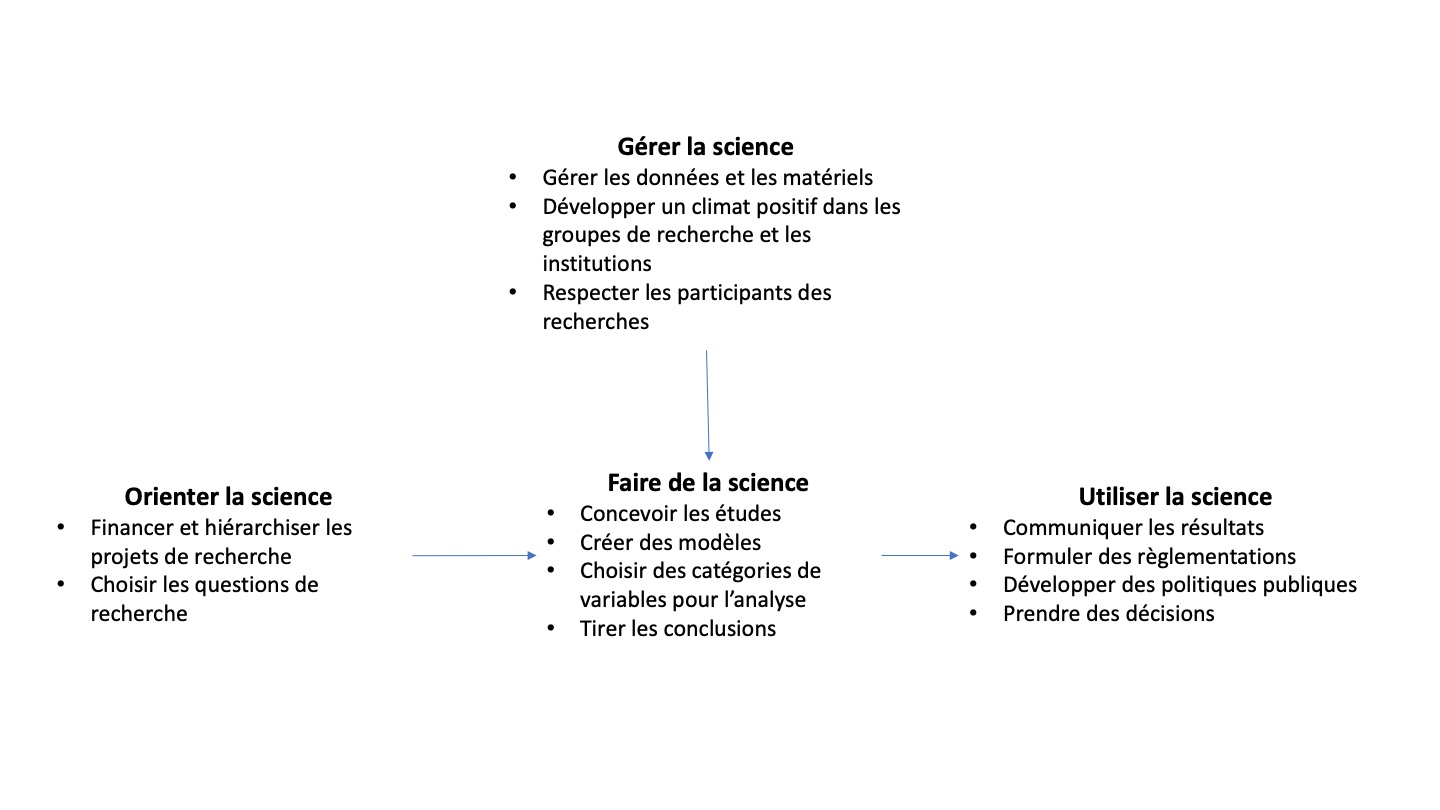

Selon [Elliott, 2022] (p. 8) (voir Figure 2 ci-dessous), les valeurs peuvent impacter les quatre phases standard de la plupart des processus de recherche, détaillés ci-après.

Figure 2 — Un cadre présentant les étapes de recours à la science, issue de [Elliott, 2022] (p. 8).

Orienter la science#

Tout d’abord la phase de pilotage de la recherche (steering), les valeurs influencent les financements de recherches sur l’IAED, via les appels à soumission à des projets de recherche et les financements de thèse. Les instituts de recherche en IA créés via l’appel à manifestation d’intérêt 3IA en sont un exemple, mais également des organismes comme l’ANR, le CNRS, les universités, les autres ministères (comme celui des armées) et les entreprises. Évaluer des valeurs dès ce niveau est important car l’utilisation de financements provenant de tel ou tel organisme va permettre de développer des recherches dont les valeurs peuvent être incompatibles avec celles des chercheurs. Les financements, lorsqu’ils proviennent de sources éthiquement douteuses, peuvent avoir un retentissement important et amener la démission de chercheurs (cf. celle de J. Ito, directeur du MediaLab du MIT, financé par le milliardaire pédo-criminel J. Epstein [Ochigame, 2019]). Il n’est pas non plus anodin que les GAFAM consacrent des moyens importants à élaborer des principes éthiques (Fairness Flow, l’algorithme de détection de biais de FaceBook ; AI Fairness 360 d’IBM, etc.).

Faire de la science#

Ensuite faire de la recherche (doing), les valeurs influencent les chercheurs réalisant des travaux dans le domaine de l’AIED. Les chercheurs peuvent se poser des questions de recherche différentes, avoir différentes méthodes ou stratégies de recherche, aboutir à des conclusions différentes, en fonction des valeurs ou des priorités qu’ils considèrent ([Elliott, 2017], p. 58). Les théories et méthodes qu’ils choisissent et auxquelles ils réfèrent ont un impact sur les résultats de leurs recherches (utilisent-ils tel ou tel corpus, telle ou telle méthode d’analyse de données ? telle ou telle preuve de l’efficacité d’une méthode ?).

Un courant critique prétend que l’IAED (mais aussi, plus largement, les études fondées sur les données probantes, voir [Biesta, 2020]) influence négativement la recherche, en concentrant la recherche sur ce qui peut être mesuré vs. ce qui ne peut pas être mesuré, et qu’en conséquence cela valorise injustement les pratiques mesurables au détriment des pratiques non mesurables. Il prétend en outre que la mesure déforme la vérité de ce qui est mesuré.

Gérer la science#

En parallèle à la dernière activité, les chercheurs doivent gérer (managing) l’organisation de leurs travaux, ce qui amène à considérer des valeurs en lien avec la gestion des données, mais aussi l’ambiance de l’équipe et les participants aux études. Cette phase est utile pour tester les prototypes.

Enfin, une fois que les systèmes sont opérationnels, les valeurs concernent à la fois la publication et la communication des résultats, mais aussi dans quelle mesure les utilisateurs sont concernés par l’utilisation des systèmes, comment ces systèmes peuvent impacter les pratiques sociales, etc. L’opinion des différents utilisateurs sur l’acceptabilité ou l’utilisabilité des systèmes, s’ils en deviennent les utilisateurs directs, entre également dans cette catégorie.

Tableau II — Liste de valeurs par phase de la recherche, ou domaine.

Types de valeurs ou phase d’utilisation |

|

|---|---|

Éducatives |

Discussion ou communication |

Empathie |

|

Coopération |

|

Tolérance |

|

Créativité |

|

Autonomie |

|

Responsabilité |

|

Émancipation |

|

Réflexion |

|

Engagement |

|

Solidarité, inclusion |

|

Orienter la recherche |

Absence de conflit d’intérêt |

Préservation de l’environnement |

|

Se centrer sur des caractéristiques mesurables sans dévaloriser le non mesurable |

|

Financeurs des recherches respectueux des valeurs des chercheurs |

|

Gérer la recherche |

|

Protection et respect des participants |

Bien-être physique, mental et matériel |

Courtoisie et calme |

|

Respect de l’identité |

|

Prise en compte des aspects culturels |

|

Absence de biais |

|

Respect de la vie privée |

|

Consentement éclairé |

|

Sécurité physique et mentale |

|

Propriété de ses données |

|

Confiance |

|

Droits des travailleurs (micro-travail, notamment) |

|

Protection des lanceurs d’alerte |

|

Gérer la recherche |

|

Devoirs des chercheurs |

Responsabilité |

Faire la recherche |

|

Propriété des systèmes conçus |

Respect de la conscience du public aux risques potentiels de l’IA |

Attention au risque de contrôle ou supervision excessive |

|

Conformation du système aux dispositions légales |

|

Robustesse technique et sécurité des données |

|

Utilisabilité universelle |

|

Explicabilité et transparence |

|

Communiquer la recherche |

|

Anonymisation des données et résultats communiqués |

|

Science ouverte |

Replacer les valeurs : une liste de questions de cadrage#

Le cadre ci-dessus étant posé, nous pouvons poser, phase après phase, une série de questions dont les réponses peuvent être utiles pour analyser les aspects reliés aux valeurs. En nous référant à [Holmes & Tuomi, 2022], nous distinguerons les applications centrées sur les élèves, celles centrées sur les enseignants, et celles centrées sur l’administration ou l’institution.

Orienter la recherche#

Déterminer et comprendre les valeurs des organismes et entreprises (ou les partenaires) qui financent les travaux en IAED peut être d’une grande aide pour les chercheurs, d’une part, et les utilisateurs finaux, d’autre part. La difficulté spécifique de l’IAED est que les financeurs peuvent venir de deux milieux très différents : de l’industrie du logiciel (start-up, etc.) et de l’éducation. La question ici est de déterminer les éventuels conflits entre les valeurs des chercheurs et celles des organismes qui financent ces recherches.

Quels sont les produits vendus (ou les activités) des organismes et partenaires qui financent la recherche ?

Quelles sont leurs valeurs ? Pourquoi ont-ils décidé de financer ces recherches ? Pour quel profit financier ou symbolique ?

Quelles contradictions possibles peuvent (ou pourraient) émerger entre les valeurs de ces organismes et partenaires et celles des autres protagonistes ?

Dans quelle mesure ces conflits de valeurs peuvent-ils mettre en difficulté la bonne marche de la suite du processus de recherche ?

Comment rendre clairs les liens entre ces organismes et partenaires et les recherches poursuivies ? (notamment en déclarant ces liens pour que de possibles conflits d’intérêt puissent être détectés).

À titre d’exemple, l’institut MIAI (Univ. Grenoble Alpes) a de très nombreux partenaires appartenant à de nombreux champs (industrie, mutuelles, associations) et pouvant avoir des valeurs contradictoires. Comment sont réglés les possibles conflits de valeurs au sein de MIAI et ces partenaires ?

Faire de la recherche#

Les cadres théoriques et les méthodes utilisés, les résultats tirés des études et les conclusions établies peuvent aussi être dépendants de valeurs. Les questions suivantes peuvent être posées dans cette étape :

Quel cadre théorique (ou modèle, méthode) est utilisé dans la recherche ? Selon leur centration sur tel ou tel élément (cognition, comportement, environnement, enseignant, élèves ou administratifs), quels présupposés amènent-ils du point de vue des valeurs ? Par exemple, si un système est conçu pour augmenter l’autonomie ou l’engagement des élèves, les données qu’il récupère à cette fin, ou leur traitement sont-ils compatibles avec ce but ? [Hansen & Komljenovic, 2022].

Les résultats tirés de la recherche donnent-ils à voir des utilisations sociales de cette recherche pouvant être compatibles (ou pas) avec certaines valeurs ?

Les conclusions tirées des résultats de recherche révèlent-ils des éléments de l’activité étudiée (enseignement, apprentissage, administration) pouvant être compatibles (ou pas) avec certaines valeurs ?

Gérer la recherche#

Sont ici considérées les données (notamment, mais pas uniquement, les traces) récupérées des utilisateurs (de prototypes et de produits finaux) pouvant être utilisées, stockées, et analysées de diverses manières ; ainsi que les protocoles de recherche accueillant les participants des recherches. Cette question est aussi à propos de l’expérience des participants.

La ou les recherche·s réalisée·s répondent-elles aux standards de protection des données (RGPD, CNIL, etc.) ? (par exemple, à qui appartiennent les données recueillies ? Peuvent-ils sans dommage ne pas prendre part au recueil, ou en sortir (et leurs données se voir effacées) ? Peuvent-ils agir dessus ? les modifier ?). Quand peut-on dire qu’on a trop de données [Gigerenzer, 2022] ? Sont-elles bien reliées au contexte plutôt qu’aux présupposés des chercheurs ? Quelles données s’interdire a priori de collecter (e.g., émotions, voir [Bartoletti, 2023], p. 80-81). À qui appartiennent les données ? aux chercheurs ? aux enseignants ? aux apprenants ? Les intéressés peuvent-ils savoir clairement quelles données sont traitées ? À quelles fins ? Pour quels processus (voir ensuite)

Le recueil des données est-il sujet à des biais ? des problèmes de représentation ? (les données recueillies sont-elles suffisamment représentatives des participants)

Les dispositifs (set-up) des études réalisées avec le système sont-ils (ou pas) compatibles avec certaines valeurs ? Peuvent-ils par exemple gêner, mettre mal à l’aise certaines catégories de participants ?

Les outputs des systèmes utilisés dans les recherches sont-ils (ou pas) compatibles avec certaines valeurs ? Par exemple, le système peut-il induire des différences de traitement entre des types d’utilisateurs (e.g., selon leur genre, leur besoins particuliers, leur statut social, ou leur couleur de peau) ? Si oui, est-ce pour des problématiques de recherche suffisamment justifiées ?

Utiliser la recherche#

On considère ici la manière dont les résultats de la recherche peuvent avoir un impact social, via leur communication mais aussi leurs effets sur des réglementations administratives.

La communication des résultats de la recherche peut-elle avoir un impact sur certaines valeurs ?

La recherche a-t-elle un impact sur certaines réglementations ? Amène-t-elle à reconsidérer certaines valeurs ou pratiques ?

La responsabilité des concepteurs du système ne s’arrête bien sûr pas à sa réalisation [Gray & Boling, 2016]. Peut-on envisager des effets à plus long terme de l’outil, qu’ils soient positifs ou délétères, selon leur utilisation ?

Discussion#

Il peut être judicieux d’utiliser ce cadre éthique, par exemple pour concevoir et animer des défis éthiques dans les établissements et universités [Akgun & Greenhow, 2022].

Ce cadre de réflexion éthique est utile pour ne pas seulement détecter les mauvaises conduites a posteriori, mais aussi proposer des éléments pro-actifs (Holmes et al., 2021). Par exemple (cité par [Holmes & Porayska-Pomsta, 2023], p. 11) : vouloir rendre un outil de proctoring (surveillance des examens) plus juste sans se poser la question du proctoring.

Décrire un système IAED#

Cette partie reprend pas à pas le cadre décrit dans la partie précédente, pour permettre à tout·e concepteur·ice de système IAED de réfléchir aux valeurs impliquées.

Description succincte du ou des système·s considéré·s#

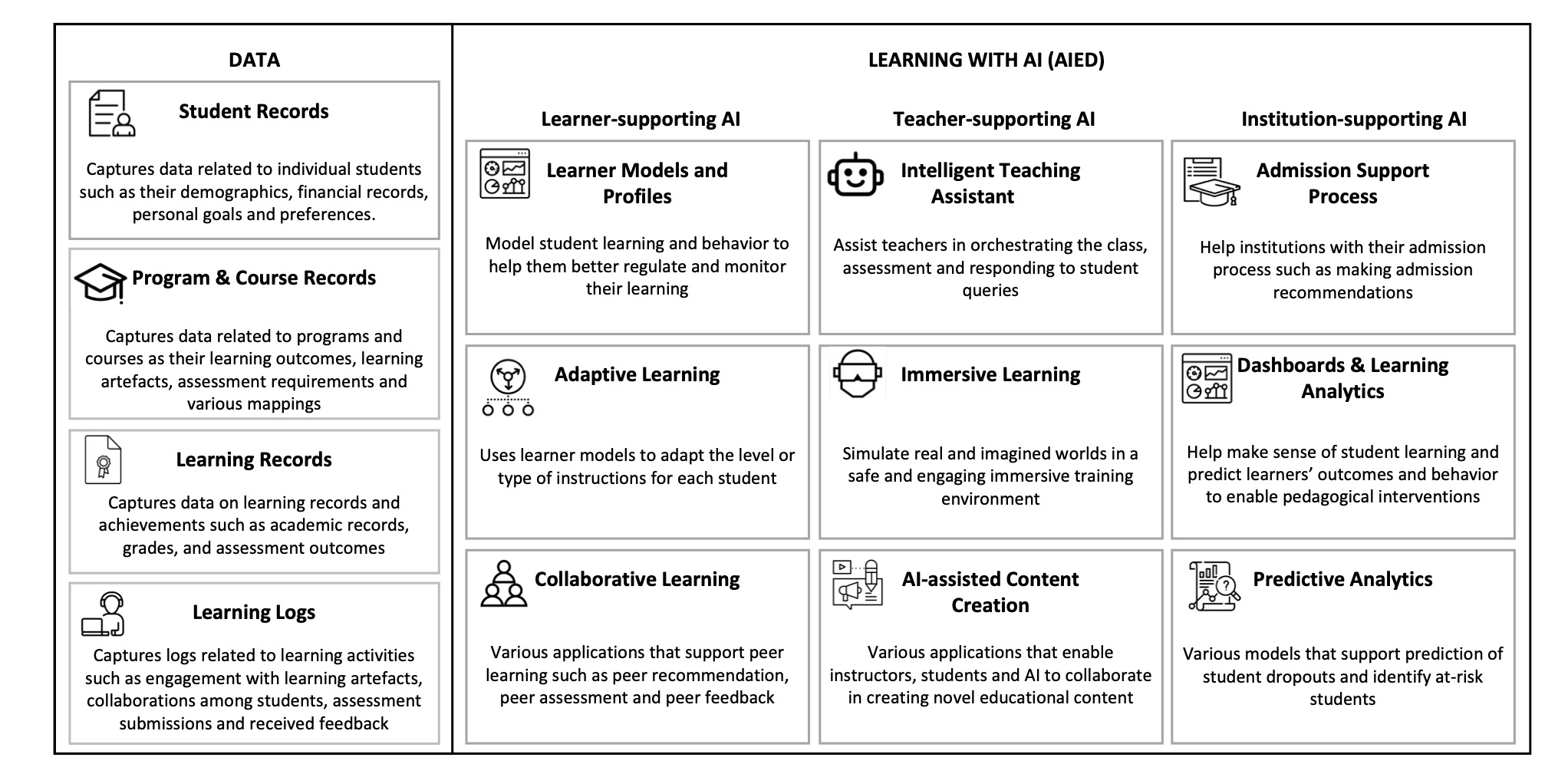

Tout d’abord, décrire en un ou deux paragraphes le·s système IAED développé·s dans l’équipe en les classant selon la typologie de [Khosravi et al., submitted], donnée ci-dessous. Identifier précisément le contexte d’enseignement-apprentissage (centré étudiant, enseignant, ou administration), les input-output et les données capturées, leur type de traitement.

Figure 3 — Catégorisation des principaux types d’utilisation de l’IA dans l’éducation [Khosravi et al., submitted], p. 2.

Sélectionner une sous-partie du système : valeur, technologie, contexte d’utilisation#

Ensuite, sélectionner dans la fiche une sous-partie significative de votre système (pour éviter que l’analyse soit trop complexe), un contexte d’utilisation, et quelques valeurs principales (cf. Tableau II).

Exemple : Dans le projet Teaching Lab, nous sélectionnons la phase de capture et analyse vidéo des micro-expressions faciales et de la posture des étudiants.

Identifier les utilisateurs directs et indirects#

Comme indiqué plus haut, identifier les utilisateurs directs du système (ceux qui interagissent directement avec le système) et ceux qui peuvent être affectés par le système sans interagir directement avec lui).

Exemple : Dans Teaching Lab, les utilisateurs directs sont les chercheurs ; les utilisateurs indirects sont les enseignants et les étudiants puisqu’ils n’interagissent pas directement avec le système. Notons toutefois qu’une interaction minimale est prévue : celle où un appui sur un bouton sur un mur de la salle arrête la capture en cours et supprime le fichier vidéo de la séance.

Bénéfices et inconvénients par valeur#

Pour chaque groupe, identifier les bénéfices et inconvénients de chaque groupe d’utilisateurs, et les valeurs pouvant y être reliées.

Exemple : Dans Teaching Lab, les chercheurs se servent des captures et analyses pour comprendre les liens entre changements d’expression et engagement des étudiants. Les enseignants, après séance de cours, peuvent tirer parti des analyses précédentes pour analyser leur pratique d’enseignement et déterminer les plus efficaces, au détriment d’une surveillance sur la durée du cours. Les étudiants peuvent, eux aussi, avoir un avantage à comprendre ce qui les engage et désengagent dans un cours, là aussi au détriment d’une surveillance sur la durée du cours.

Volet éducation#

Déterminer quelle·s facette·s de l’éducation votre système promeut (socialiser, vérités du monde réel, développement individuel).

Exemple : Dans Teaching Lab, la facette la plus importante est celle de promouvoir les vérités du monde réel, puisque les enseignants se voient confrontés à des analyses fines des tenants et aboutissants de leurs choix pédagogiques.

Réponses aux questions éthiques selon le processus de la recherche#

Ensuite, prendre l’une des quatre phases de la recherche qui vous paraît la plus pertinente dans votre travail de recherche et, en prenant le système considéré comme exemple, répondre aux questions pertinentes.

Exemple : Dans Teaching Lab, nous pouvons réfléchir à l’étape “Faire de la recherche”. Le cadre théorique utilisé est celui de l’engagement (comportemental et émotionnel) des étudiants. Le but est d’utiliser un système d’IA pour étiqueter automatiquement les comportements et changements émotionnels de haut ou bas niveau, et pouvoir par cela procurer une évaluation des conséquences de telle ou telle méthode pédagogique. À cet effet, il est donc nécessaire de récupérer des informations sur la posture (direction du buste, de la tête) et sur les micro-expressions faciales. Cela ne paraît pas être un prélèvement de données excessif par rapport au but. Les analyses faites à ces propos ne seront jamais communiquées aux utilisateurs en direct, afin d’éviter toute interférence ou surveillance, mais a posteriori, dans des temps de debriefing. Il est encore trop tôt pour élaborer des conclusions fermes à propos de ce projet, puisque nous n’avons pas commencé à en récolter des données.